¿Alguna vez has escuchado hablar del archivo “robots.txt”? Por si no lo sabes, se trata de una herramienta muy importante para el control del rastreo de los robots de los motores de búsqueda en un sitio web. En este artículo te explicaré qué es el archivo “robots.txt”, cómo funciona, por qué es crucial para tu sitio web y te daré algunas recomendaciones. Acompáñame en este viaje para aprender un poco más sobre este tema tan interesante.

¿Qué es robots.txt?

El archivo robots.txt es una herramienta fundamental para cualquier propietario de un sitio web que desee tener un mayor control sobre cómo los robots rastrean e indexan su contenido. En esta mini guía sobre robots.txt, aprenderás qué es, cómo funciona y cómo puedes aprovecharlo para mejorar tu SEO y optimizar tu sitio web.

Los robots o arañas son programas de computadora que recorren Internet para encontrar información y páginas web. Son como exploradores que visitan diferentes sitios web y recopilan datos para que luego puedas buscar cosas en Internet.

El archivo robots.txt

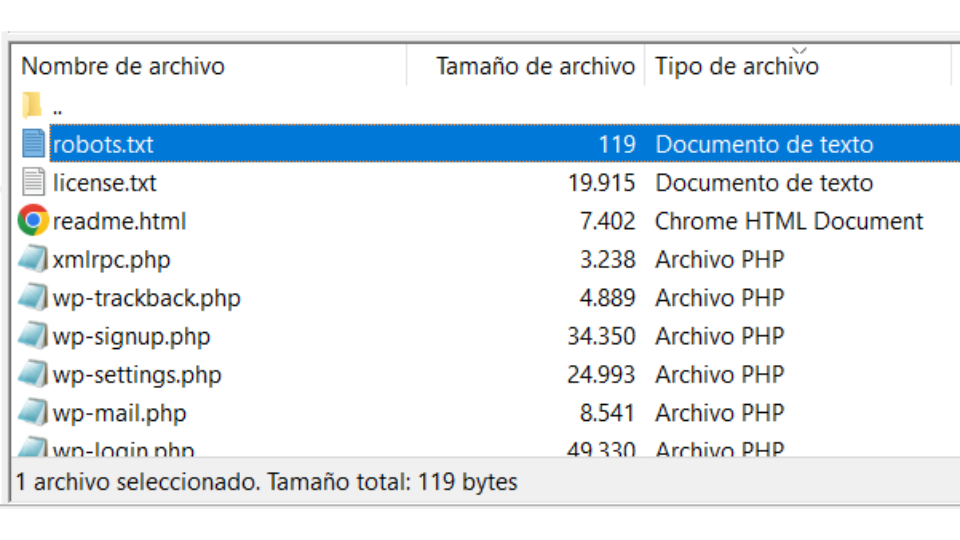

El archivo robots.txt es un archivo de texto ubicado en el directorio raíz de un sitio web que proporciona instrucciones a los robots web sobre qué páginas o directorios deben rastrear y cuáles deben ignorar. Si bien su uso no garantiza que los robots cumplan con las instrucciones, muchos rastreadores bien intencionados, como los de los motores de búsqueda, lo respetan y ajustan su comportamiento en consecuencia.

Ejemplo de robots.txt

A continuación, te dejo un ejemplo básico del archivo robots.txt:

User-agent: *

Disallow: /directoriorestringido/

Disallow: /archivoprivado.htmlEn el ejemplo anterior, la línea “User-agent: *” indica que las reglas que se describen a continuación, se aplican a todos los robots. Las reglas de las líneas 2 y 3 que comienzan con “Disallow:” especifican los directorios o archivos que deben evitarse. En este caso, se prohíbe el acceso al directorio “/directoriorestringido/” y al archivo “/archivoprivado.html”.

También, puedes especificar diferentes user-agents en el archivo robots.txt para aplicar reglas específicas a distintos motores de búsqueda. Por lo que deberás cambiar el asterisco (*) por el nombre del bot. Aquí tienes un ejemplo de cómo podrías restringir el contenido para dos user-agents diferentes Google y Bing:

User-agent: Googlebot

Disallow: /directoriorestringido/

User-agent: Bingbot

Disallow: /archivoprivado.html

Disallow: /otrodirectoriorestringido/En el ejemplo anterior, se establecen reglas diferentes para dos user-agents: “Googlebot» y «Bingbot«. La primera sección indica que el directorio “/directoriorestringido/” no debe ser rastreado por el robot de Google, mientras que la segunda sección indica que tanto el archivo «/archivoprivado.html» como el directorio “/otrodirectoriorestringido/” no deben ser rastreados por el robot de Bing.

Como puedes ver, siguiendo con la estructura anterior, resulta fácil agregar más secciones para otros user-agents si deseas aplicar reglas específicas para diferentes motores de búsqueda. Recuerda que el asterisco (*) se utiliza como comodín para representar cualquier user-agent no especificado en el archivo.

¿Cómo funciona robots.txt?

El archivo robots.txt funciona como una especie de “señal” que le indica a los robots o arañas web qué partes de un sitio web pueden rastrear y cuáles no. Es como un mapa que les muestra dónde pueden ir y dónde no.

Cuando un robot visita un sitio web, lo primero que hace es buscar el archivo robots.txt en la raíz del sitio. Luego, el robot lee las reglas y directivas especificadas en ese archivo.

El archivo robots.txt utiliza una sintaxis simple con diferentes directivas. Como has visto en los ejemplos anteriores, la directiva “Disallow” se usa para indicar qué directorios o archivos no se deben rastrear. Por otro lado, la directiva “Allow” se emplea para especificar qué partes del sitio pueden ser rastreadas.

Los robots web respetan estas instrucciones y ajustan su comportamiento en consecuencia. Si un robot encuentra una regla que le indica no rastrear un directorio específico, no lo visitará. Esto es útil cuando se desea proteger información privada o restringir el acceso a ciertas secciones del sitio.

Advertencia: No uses un archivo robots.txt para impedir que tus páginas web aparezcan en los resultados de la Búsqueda de Google.

Es posible que acaben indexándose, aunque no se visiten, si hay otras páginas que dirigen a ella con texto descriptivo. Si quieres bloquear una página para que no aparezca en los resultados de búsqueda, usa otro método. Por ejemplo, protégela con una contraseña o utiliza una directiva noindex.

Fuente: https://developers.google.com/search/docs/crawling-indexing/robots/intro?hl=es

Es importante destacar que los robots pueden optar por no respetar el archivo robots.txt y rastrear el contenido de todos modos. Algunos robots maliciosos incluso pueden ignorar por completo estas instrucciones. Por lo tanto, no se debe confiar únicamente en el archivo robots.txt para proteger información sensible.

Para terminar, decir que, el archivo robots.txt es una herramienta que utiliza un sitio web para indicar a los robots web qué partes pueden rastrear y cuáles no. Ayuda a controlar el acceso de los robots a diferentes secciones del sitio y es importante para la optimización y la privacidad online.

Recomendaciones clave para utilizar el archivo robots.txt

- Conoce las directivas: Además de «Disallow:«, existen otras directivas útiles, como «Allow:» para permitir acceso a directorios o archivos específicos, “Crawl-delay:” para establecer un tiempo de espera entre las solicitudes de rastreo, Y

"sitemap:"para indicar la ubicación de un sitemap del sitio web. Familiarízate con estas directivas para aprovechar al máximo el archivo robots.txt.

El comando “crawl-delay” especifica un retraso de rastreo en segundos. Está pensado para evitar que los rastreadores sobrecarguen un servidor (es decir, que ralenticen tu web).

- Ubica correctamente el archivo: Coloca el archivo robots.txt en el directorio raíz de tu sitio web para que los rastreadores puedan encontrarlo fácilmente. La ubicación típica, por ejemplo, es: juanarmada.com/robots.txt.

- Utiliza comentarios: Puedes agregar comentarios en el archivo robots.txt para explicar tus reglas y hacerlo más comprensible para otros desarrolladores o administradores de sitios web. Los comentarios se inician con el símbolo «#» y no afectan el comportamiento de los robots.

- Segmenta reglas para diferentes user-agents: Si deseas aplicar reglas específicas a ciertos rastreadores, como Googlebot, Bingbot, etc., utiliza secciones separadas en el archivo robots.txt para cada user-agent y establece las restricciones correspondientes.

- Bloquea contenido sensible: Por ejemplo, utiliza la directiva “Disallow” para indicar qué directorios o archivos no deben ser rastreados por los motores de búsqueda. Esto te permite proteger contenido sensible o privado.

- Verifica la sintaxis: Un pequeño error de sintaxis en el archivo robots.txt puede tener un impacto significativo en cómo se rastrea tu sitio web. Asegúrate de que la sintaxis sea correcta y que las directivas se apliquen a los agentes de usuario y rutas específicas que deseas controlar.

- Verifica los cambios con herramientas de prueba: Antes de implementar cambios en tu archivo robots.txt en un sitio web en vivo, es recomendable utilizar herramientas de prueba o validadores online para verificar si las reglas se aplican según lo esperado y no bloquean el acceso a partes importantes de tu sitio.

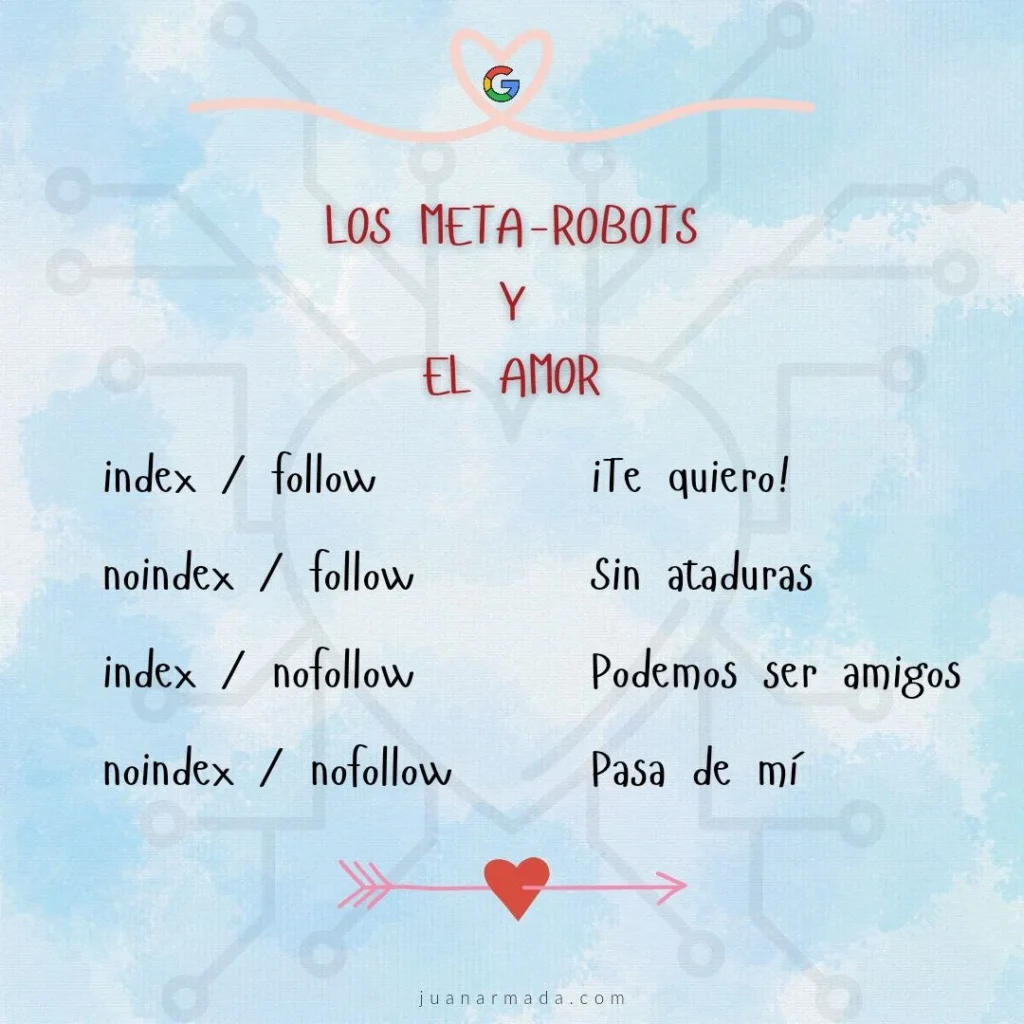

- Complementa con etiquetas meta robots: Aunque el archivo robots.txt es una herramienta poderosa, no es suficiente para proteger contenido sensible o evitar que ciertas páginas se indexen por completo. En esos casos, es recomendable utilizar etiquetas meta robots en las páginas HTML relevantes para proporcionar instrucciones adicionales a los robots web.

Los meta robots son como las señales o indicaciones que damos a los motores de búsqueda sobre cómo deben comportarse con nuestro sitio web. Son instrucciones específicas que les proporcionamos para guiar su comportamiento al indexar y rastrear nuestras páginas.

Conclusión

El archivo robots.txt es un recurso valioso para controlar el rastreo y la indexación de tu sitio web por parte de los robots web. Aprovecharlo adecuadamente te puede ayudar a mejorar tu SEO, proteger contenido sensible y optimizar la estructura de tu sitio. Al seguir las recomendaciones clave mencionadas anteriormente y comprender cómo funcionan las directivas en el archivo robots.txt, podrás maximizar los beneficios que ofrece esta herramienta.

Sin embargo, si no tienes conocimiento sobre cómo funciona el archivo robots.txt y no estás seguro de qué directivas utilizar, una opción segura es dejar el archivo en blanco, es decir, eliminar todas las directivas. Esto te evitará tener problemas de SEO.

Por otra parte, recuerda que el archivo robots.txt no garantiza la privacidad total de tu contenido ni evita el acceso de bots maliciosos. Si tienes información confidencial o páginas que deseas mantener completamente ocultas, es recomendable utilizar medidas adicionales de seguridad, como autenticación o encriptación.

Además, siempre es importante monitorear y analizar el comportamiento de los rastreadores en tu sitio web. Puedes utilizar herramientas de análisis para verificar cómo los motores de búsqueda interpretan tu archivo robots.txt y cómo están rastreando e indexando tu contenido.

Para concluir, el archivo robots.txt es una herramienta esencial en el mundo del SEO y la optimización del sitio web. Aprender a utilizarlo correctamente y aplicar las mejores prácticas te permitirá tener un mayor control sobre la forma en que los robots web interactúan con tu sitio, lo que a su vez puede mejorar la visibilidad de tu contenido y la experiencia general de los usuarios. ¡Aprovecha al máximo esta herramienta y optimiza tu presencia online!

Espero que este post te haya ayudado a comprender como funciona el archivo robots.txt y que implicación tiene con el SEO de tu sitio web.

¡Nos vemos en el siguiente post! Ciao!